9月19日,在2024杭州云栖大会上,阿里云CTO周靖人表示,阿里云正在围绕AI时代,树立一个AI基础设施的新标准,全面升级从服务器到计算、存储、网络、数据处理、模型训练和推理平台的技术架构体系,让数据中心成为一台超级计算机,为每个AI和应用提供高性能、高效的算力服务。大会现场,通义大模型还迎来了年度重磅发布。

阿里云发力AI时代最强基建

不同于传统IT时代,AI时代对基础设施的性能、效率要求更高,CPU主导的计算体系已快速向GPU主导的AI计算体系转移。阿里云将加速模型的开发和应用,打造一个AI时代的最强AI基建。

周靖人表示:“云厂商拥有全栈技术储备,并通过基础设施的全面升级,让AI训练、推理、部署和应用整个生命周期变得更高效。”

大会现场,周靖人展示了AI驱动的阿里云全系列产品家族升级。最新上线的磐久AI服务器,支持单机16卡、显存1.5T,并提供AI算法预测GPU故障,准确率达92%;阿里云ACS首次推出GPU容器算力,通过拓扑感知调度,实现计算亲和度和性能的提升;为AI设计的高性能网络架构HPN7.0,可稳定连接超过10万个GPU,模型端到端训练性能提升10%以上;阿里云CPFS文件存储,数据吞吐20TB/s,为AI智算提供指数级扩展存储能力;人工智能平台PAI,已实现万卡级别的训练推理一体化弹性调度,AI算力有效利用率超90%。

过去两年,模型的尺寸已增长数千倍,但模型的算力成本正在持续下降,企业使用模型的成本也越来越低。周靖人强调:“这是AI基础设施全面革新带来的技术红利,我们会持续投入先进AI基础设施的建设,加速大模型走进千行百业。”

阿里云百炼平台上的三款通义千问主力模型再次降价。Qwen-Turbo价格直降85%,低至百万tokens 0.3元,Qwen-Plus和Qwen-Max分别再降价80%和50%。其中,Qwen-Plus推理能力追平GPT4,降价后,Qwen-Plus性价比达到业界最高,同等规模较行业价格低84%。

周靖人表示:“为应对GPU算力的指数级增长需求,尤其是即将爆发的推理市场,阿里云已经准备好了。”

阿里云大模型全面升级 引领AI技术创新潮流过去一年,大模型技术实现了多个里程碑式跨越。作为业内最早布局大模型技术的科技公司之一,去年4月,阿里云发布首个大语言模型通义千问。

大会现场,周靖人重磅宣布,通义旗舰模型Qwen-Max全方位升级,相比上一代模型,Qwen-Max在训练中使用了更多的训练数据、更大的模型规模、更强的人类对齐,最终达到了更高的智能水平。在MMLU-Pro、MATH、GSM8K、MBPP、MultiPL-E、LiveCodeBench等十多个权威基准上,Qwen-Max表现接近GPT-4o,数学能力、代码能力则超越了GPT-4o。数学和代码所代表的推理能力是大模型智能水平的最重要体现。

相比2023年4月的初代通义千问大模型,Qwen-Max的理解能力提升46%、数学能力提升75%、代码能力提升102%、幻觉抵御能力提升35%、指令遵循能力提升105%,模型与人类偏好的对齐水平更是有了质的飞跃,提升了700%以上。

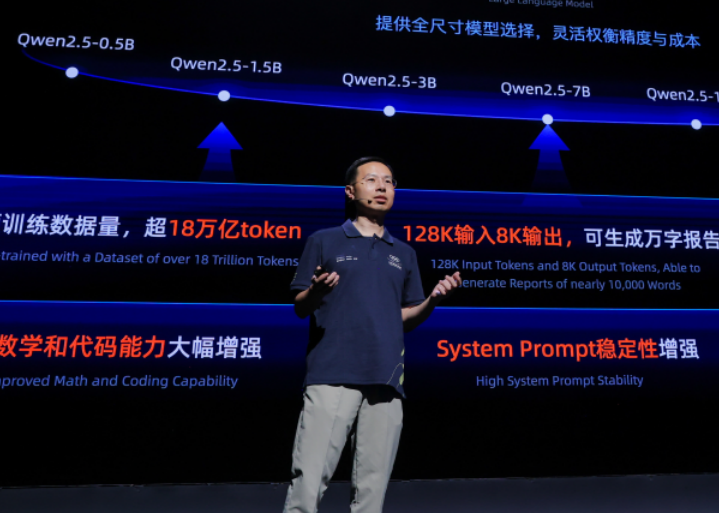

同时,还发布最强开源模型Qwen2.5系列,其中,旗舰模型Qwen2.5-72B性能超越Llama 405B,再登全球开源大模型王座。Qwen2.5涵盖多个尺寸的大语言模型、多模态模型、数学模型和代码模型,每个尺寸都有基础版本、指令跟随版本、量化版本,总计上架100多个模型,刷新业界纪录。截至2024年9月中旬,通义千问开源模型累计下载量已突破4000万,成为仅次于Llama的世界级模型群。

面向编程场景,阿里云通义灵码迎来重磅升级,从一年前只能完成基础的辅助编程任务,进化到几句话就能完成需求理解、任务拆解、代码编写、修改BUG、测试等开发任务,最快几分钟可从0到1完成应用开发,提升数十倍开发效率。目前,通义灵码已广泛应用于金融、制造、互联网、交通、汽车、能源等行业。在Gartner首个AI代码助手魔力象限报告中,阿里云成为唯一进入挑战者象限的中国科技公司。

此外,通义万相也进行了全面升级,全新发布的视频生成模型,可生成影视级高清视频,可应用于影视创作、动画设计、广告设计等领域。

百模大战一年后,应用成为大模型产业的主旋律。作为最早提出模型即服务(MaaS)理念的企业,阿里云一直把大模型生态的繁荣作为首要目标。目前,魔搭社区已成为中国最大的模型社区,拥有超690万开发者用户,与行业合作伙伴合作贡献了超10000款模型。

“我们希望企业和开发者能以最低的成本做AI、用AI,让所有人都能用上最先进的大模型。”周靖人说。