人工智能数据工程未来将从单一环节的效率提升转向全链条的系统化升级,逐步构建起覆盖管理、技术、质量、运营、合规的立体化发展格局。企业通过“五大核心要素”能力体系构建和“体系规划、工程建设、质量监测”“三步走”战略,不仅实现数据资源的深度整合与高效利用,更将数据优势转化为模型迭代与业务创新的核心动能。

一、体系规划阶段:构建高质量数据集认知框架

企业构建人工智能高质量数据集体系,规划阶段需以资源知识索引、地图构建、标准体系搭建为核心,驱动数据集系统化规划和建设。

1. 围绕智能化需求,构建知识索引框架

企业需结合行业特性,提炼核心知识节点,搭建层次化知识架构,将既有数据资源与知识索引匹配,可实现数据的知识化归类。同时,知识索引为模型应用提供结构化路径,研发人员可依托索引快速调用关联数据,加速模型训练迭代,让数据资源转化为驱动业务创新的智能生产力,最终实现从数据到模型的价值跃升。

2. 锚定智能场景,构建企业人工智能数据资源地图

企业需深入拆解模型业务场景,明确场景对应的核心数据类型与质量要求,形成数据集设计方案。继而全面梳理内部数据资源,盘点数据目录清单,清晰标注数据类型(用户行为、设备运行数据等)、存储状态(实时流数据、历史归档数据)及权属关系。通过绘制资源地图,企业实现数据集的可视化呈现,形成“数据地图导航”能力。这不仅能快速定位场景所需数据,规避重复采集或资源浪费,更让数据检索从“模糊搜寻”转向“按图索骥”,为后续数据集开发提供精准指引,推动数据与智能场景的高效适配。

3. 搭建标准体系,指导面向人工智能全周期高质量数据集建设

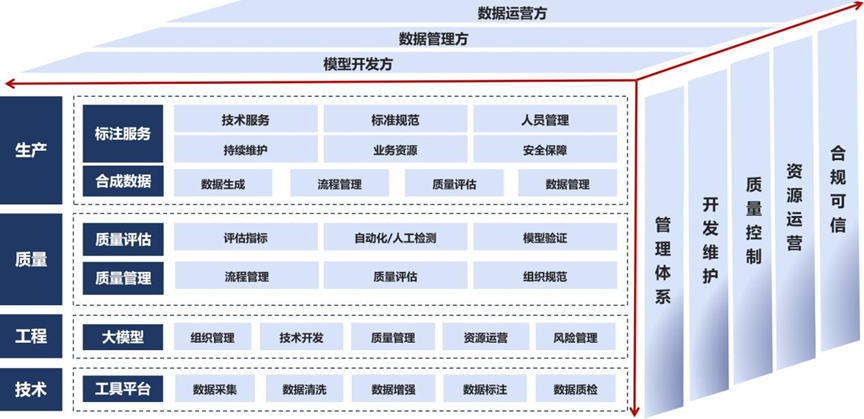

围绕标注服务、合成数据等生产活动,制定数据标注规范、合成数据质量标准,结合技术服务、流程管理要求,保障数据生产规范化。明确质量评估指标,规范自动化/人工检测流程,建立质量管理组织规范,确保质检环节有章可循,提升数据可靠性。在大模型应用端,制定数据与模型对接标准,规范资源运营、风险管理流程。针对工具平台,统一数据清洗、标注、存储等技术工具开发标准,保障工具兼容性与易用性。通过覆盖生产、质检、应用、技术的标准体系,企业可实现数据工程全链条标准化管理,减少模型开发方、数据运营方、数据管理方协作误差,提升数据质量控制与合规可信水平。按照上述思路要求,中国信息通信研究院已经建立了三维人工智能数据工程评估体系(见图1)。

图1 中国信息通信研究院人工智能数据工程评估体系(ADA)

二、工程建设阶段:打造高质量数据集生产体系

在企业构建人工智能高质量数据集体系的工程建设阶段,打造高质量数据集生产体系需从三大方向协同发力,以技术驱动、模式创新与生态协同筑牢数据根基:根据工厂模式奠定规模化生产基础,前沿技术突破质量与场景限制,生态协作整合外部资源,共同构建起覆盖效率、质量、创新高质量数据集生产体系,为人工智能应用提供核心数据动能。

1. 建立高效数据工厂模式,推动规模化生产

高效数据工厂模式以标准化、流水线作业为核心,重构数据生产流程。企业可参照工业制造逻辑,将数据生产拆解为采集、清洗、标注、质检等模块化环节,每个环节制定精细化操作规范。例如,在图像数据生产中,明确采集设备参数、清洗过滤规则、标注分类标准及质检抽检比例,形成“输入—处理—输出”的标准化流水线。同时,引入自动化工具提升生产效能,如开发自动化数据清洗脚本,批量处理重复、错误数据;搭建智能标注平台,通过预设标签模板、自动推荐标注结果,减少人工操作成本。这种模式不仅实现数据生产的规模化扩张,更通过流程管控降低人为误差,确保数据质量稳定性,为大模型训练提供持续、可靠的数据源。

2. 探索前沿技术路线,突破传统数据局限

一是合成数据技术模拟真实场景生成稀缺数据,解决数据标注成本高、敏感数据获取难等问题。二是智能化标注技术借助小样本学习、主动学习等AI算法,辅助人工标注。模型自动预标注数据,标注员仅需审核修正,大幅提升标注效率。三是深度推理思维链数据聚焦模型逻辑可解释性,采集记录数据推理过程的思维链信息。

3. 构建生态协作机制,整合外部资源力量

生态协作机制通过引入外部资源,扩大数据生产“朋友圈”。企业需建立开放合作体系,引入专业第三方数据标注服务商,借助其规模化团队与丰富经验,分担数据生产压力。同时,构建科学的供应商评价和管理体系,从标注质量、交付时效、数据安全等维度设定评估指标。定期对服务商进行考核,筛选优质合作伙伴,淘汰不达标团队。此外,推动生态内协同创新,与高校、科研机构合作探索数据生产新技术,与上下游企业共建数据共享联盟,共同优化数据生产标准。通过生态协作,企业突破自身资源局限,在保障数据生产规模的同时,借助外部专业力量提升数据生产的专业性与创新性,形成多方共赢的数据生产生态。

三、质量监测阶段:构建高质量数据集全流程管控机制

质量监测阶段的全流程管控机制,通过量化评估奠定技术基础,动态机制实现过程把控,持续优化闭环推动迭代升级,三者协同构建严密的数据质量保障体系,为企业人工智能高质量数据集体系筑牢质量防线。

1. 量化评估模型和工具,构建科学评估基准

量化评估模型与工具是数据质量管控的技术基础,企业需针对数据生产各环节,设计精细化量化指标体系。例如,在数据标注环节,以标注准确率、一致性、覆盖率为核心指标,通过计算标注结果与真实标签的匹配度量化质量;在数据清洗环节,以错误数据过滤率、完整性提升率衡量工具效能。同时,引入自动化评估工具,开发集成式质量检测平台,内置AI算法自动扫描数据缺失值、异常值,生成可视化报告。如利用AI检测模型快速校验文本语义一致性、图像标注准确性,替代人工抽检,提升评估效率与精准度,为质量管控提供科学依据。

2. 动态评估机制,贯穿事前事中事后全流程

动态评估机制以时序化管理实现质量全程把控。事前规划,生产前明确质量标准与流程,制定数据采集规范、标注规则,设定质量准入门槛,从源头控制数据生产。事中监控,生产过程中部署实时监测系统,追踪标注进度、清洗效果,对超标的错误率即时预警,触发人工复核,避免问题累积。事后复盘,生产完成后系统性复盘,对比质量目标与实际结果,分析偏差原因。如针对模型训练中的数据偏差,回溯采集、标注环节,定位漏洞并形成改进方案,实现质量问题早预防、早发现、早解决。

3. 持续优化闭环,建立数据与模型的反馈联动

持续优化闭环以模型效果为导向,形成质量提升循环。企业需搭建反馈评价体系,将模型训练、应用结果反向传导至数据生产环节。例如,若模型准确率下降,溯源定位数据标注错误或缺失,启动修正流程。同时,建立常态化反馈机制,分析模型性能指标(准确率、召回率等)与数据质量的关联,总结影响规律,优化生产流程(调整标注规则、升级清洗算法),形成“模型反馈—质量诊断—流程优化”的闭环。通过持续迭代,数据质量与模型性能相互促进,推动数据集体系向更高质量演进,确保人工智能应用基于优质数据释放最大价值。

高质量数据集建设将逐步形成“数据—算法—应用”的生态协同,以标准化体系破解跨域协作难题,以智能化工具提升数据生产效能,以合规可信框架保障数据要素安全流通。高质量数据集不仅是技术竞争的 “硬实力”,更将成为产业升级的 “催化剂”,为“人工智能+”场景落地开辟无限可能,助力我国在全球智能产业变革中抢占先机、引领未来。